SK하이닉스는 지난해 6월 세계 최초로 HBM3를 양산한데 이어, 올해 4월에는 현존 최고 용량인 24GB HBM3 신제품을 공개한 바 있다. 두 회사 모두 고대역폭 메모리인 HBM3에 올해 전반의 실적과 성과를 걸고 있는 모습이다.

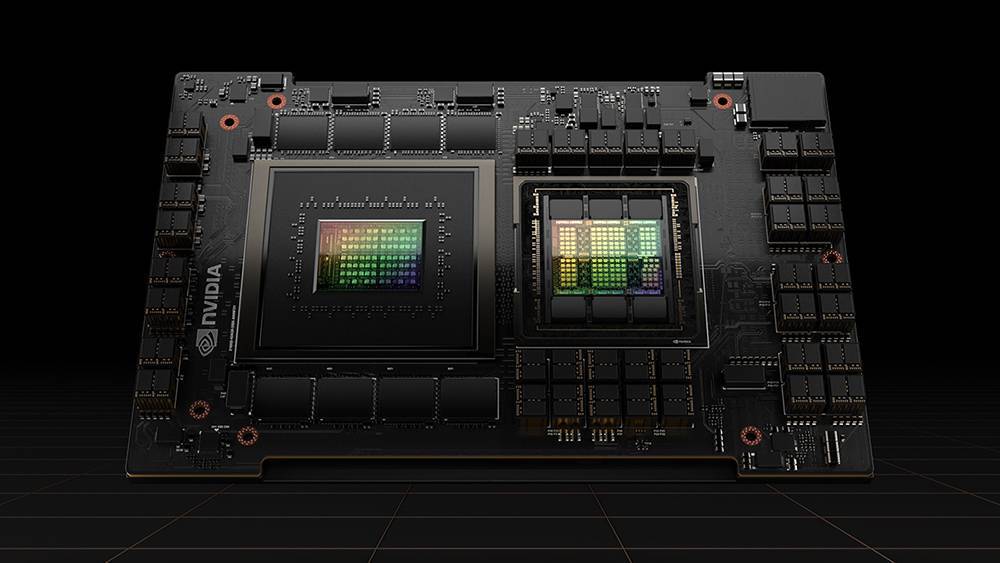

두 회사 말고도 HBM3에 사활을 거는 회사가 한둘이 아니다. 인공지능 반도체의 대장격인 엔비디아는 엔비디아 호퍼 H100 데이터센터 GPU에 120GB 용량의 HBM3를 탑재하고 있고, AMD의 데이터센터 APU인 인스팅트 MI300도 HBM3를 탑재한다. 인텔 역시 차세대 데이터 서버용 GPU(코드명 팔콘 쇼어)에 최대 288GB 용량의 HBM3 메모리를 탑재할 예정이고, 국내에서도 퓨리오사AI가 인공신경망 반도체(NPU) 제조사로는 최초로 2세대 칩인 레니게이드에 HBM3를 탑재한다. 전 세계 반도체 시장에서 빠지지 않고 등장하는 HBM3란 어떤 메모리인 걸까?

HBM3, 메모리 수직 연결해 대역폭 늘린 신 기술

HBM(High Bandwidth Memory, 고대역폭 메모리)는 2008년 AMD와 SK하이닉스가 공동으로 개발을 주도한 차세대 메모리 규격으로, 2013년 10월 JEDEC(국제반도체표준협의기구)에 의해 산업 표준으로 제정됐다. 이후 2016년 HBM2 표준이 승인되었으며, 작년 1월에 HBM3 규격이 공식 발표됐다. 현재는 SK하이닉스와 삼성전자, 마이크론이 HBM3을 생산하고 있다.

HBM은 기존에 사용되는 D램을 수직으로 쌓고, 수천 개의 실리콘관통전극(TSV)를 설치해 데이터 처리 속도와 칩간 통신 속도를 비약적으로 끌어올린 제품이다. 쉽게 말해 D램 위에 D램을 최대 12개까지 쌓고, 이를 관통하는 통로를 만들어서 통신한다. 기존의 D램 방식에서 데이터 이동 방식이 무빙 워크라면, HBM은 엘리베이터로 데이터를 수직이동하는 방식이어서 전송 속도가 빠른 것이다.

덕분에 HBM3는 단일 칩셋으로 최대 24GB의 용량을 실현하며, 쌓아놓은 칩(스택)에서 초당 819GB의 데이터를 처리할 수 있다. 이는 1초에 5GB 영화 163편 분량을 처리할 수 있는 수준이며, 이전 세대인 HBM2E와 비교해 약 78%나 빨라진 수치다. 아울러 열 효율성이 뛰어나 발열 관리가 수월하고, 동일 용량의 D램과 비교해 에너지 소비를 크게 낮춰 전반적인 시스템 안정성도 크게 향상된다.

전력 소비와 효율 잡아야 하는 대규모 데이터 처리에 특화

HBM3는 소비자 시장보다는 대규모 컴퓨팅 자원을 필요로 하는 서버 시장에서 주목받고 있다. 예를 들어 우리나라 국가 슈퍼컴퓨터 5호기만 하더라도 전체 D램 메모리 용량이 2064TB에 달하며, 32GB 컴퓨터로 환산하면 6만4500대 분량이다. 슈퍼 컴퓨터도 메모리 자체는 PC용 컴퓨터 메모리 수십 개를 서버랙(Rack)에 장착하고 연결하는 방식이라 공간 대비 용량이나 밀도, 에너지 효율성 등이 크게 떨어진다. HBM3를 활용하면 그만큼 공간 효율을 늘릴 수 있고, 에너지 관리나 메모리 밀도 측면에서도 도움이 된다.

실제로 서버 컴퓨터에 HBM을 도입한 대표적인 사례가 2020년 6월부터 22년 6월까지 세계 1위 자리를 지킨 일본의 슈퍼컴퓨터 후가쿠(Fugaku)다. 후가쿠는 슈퍼컴퓨터로는 처음으로 HBM이 사용되었는데, 출시 당시 성능이 2위에서 5위를 합친 것보다 10%나 높았을 정도로 큰 성능 격차를 보여주었다. 현재 세계 1위 슈퍼컴퓨터이자, 후가쿠 성능의 세 배가 넘는 유일한 엑사스케일 컴퓨터인 오크릿지 연구소의 프런티어 슈퍼컴퓨터도 AMD의 HBM 기반 에픽 프로세서와 라데온 인스팅트 GPU를 기반으로 하고 있다.

특히 생성형 AI로 촉발된 인공지능 경쟁에도 HBM3가 대거 사용되고 있다. 엔비디아의 데이터센터용 그래픽 카드 중 주력 모델인 H100는 80GB 용량의 HBM3를 탑재하는데, 80GB HBM2e를 탑재한 A100과 비교해 최대 30배에 가까운 AI 처리 능력을 보여준다. CPU와 GPU가 통합된 차세대 모델인 엔비디아 GH200 그레이스 호퍼 슈퍼칩은 HBM3 대비 데이터 전송 속도가 50% 더 높은 282GB HBM3e 메모리가 탑재된다. 연산 처리에 필요한 메모리 자체의 크기를 늘려 더 많은 데이터를 한 번에 처리함으로써 인공지능 개발 효율도 폭발적으로 끌어올리는 것이다.

출처 : https://www.donga.com/news/It/article/all/20230829/120923633/1

고성능 컴퓨팅을 재정의하는 메모리, HBM3란 무엇인가?

올해 들어 삼성전자 주가가 6~7만 원대를 횡보하고 있지만, 연말에는 달라질 것이라는 기대감이 크다. 8월 들어 반도체 업황이 바닥을 찍고 상승세로 돌아갈 것이라는 관측이 나오고…

www.donga.com

'[메모리]' 카테고리의 다른 글

| e-MMC와 UFS 간 차이 (0) | 2022.01.13 |

|---|---|

| SDRAM과 DDR2, DDR3, DDR4의 차이점은 무엇인가 (0) | 2019.08.19 |

| DDR3와 DDR4의 spec 비교 (JEDEC 기준) (1) | 2018.05.09 |

| CFI(Common Flash Interface)란? (0) | 2015.12.02 |

| ddr2와 ddr3에서 타이밍을 계산하는 법 (0) | 2014.09.24 |